لابراتوار ماشینهای فکری، API آموزشی Tinker را بهطور عمومی در دسترس قرار داده و سه قابلیت کلیدی به آن افزوده است: مدل استنتاجی Kimi K2، نمونهگیری سازگار با OpenAI و ورودی تصویری از طریق مدلهای زبانی Qwen3-VL. این به مهندسان هوش مصنوعی امکان میدهد مدلهای پیشرفته را بدون نیاز به ساخت زیرساختهای آموزشی توزیعشده، بهینهسازی کنند.

کاربردهای Tinker

Tinker یک API آموزشی است که بهطور خاص بر تنظیم دقیق مدلهای زبانی بزرگ تمرکز دارد. این API به شما اجازه میدهد با استفاده از یک حلقه سادهی پایتون که روی کامپیوترهای مبتنی بر CPU اجرا میشود، داده یا محیط تقویتی، ضرر و منطق آموزشی را تعریف کنید. سپس این حلقه روی خوشهای از GPUها اجرا میشود.

API مجموعه کوچکی از ابتدائیات مانند forward_backward برای محاسبه گرادیانها، optim_step برای بهروزرسانی وزنها، و sample برای تولید خروجی را فراهم میکند. این امکانات به کاربرانی که مایل به پیادهسازی یادگیری نظارتی یا تقویتی هستند، اما نمیخواهند با مشکلات GPU سر و کار داشته باشند، کمک میکند.

انتشار عمومی و Kimi K2

تغییر اصلی این بهروزرسانی این است که دیگر نیازی به لیست انتظار نیست و کاربران میتوانند ثبتنام کرده و از مدلهای موجود و قیمتها بهطور مستقیم استفاده کنند.

مدل Kimi K2 حدود یک تریلیون پارامتر دارد و برای زنجیرههای طولانی فکر و استفاده از ابزارهای سنگین طراحی شده است.

نمونهگیری سازگار با OpenAI

نسخه جدید مسیر دیگری را اضافه میکند که با رابط تکمیلکنندههای OpenAI همخوانی دارد. یک چکپوینت مدل در Tinker میتواند از طریق یک URI مشابه به آن دسترسی داشته باشد.

ورودی تصویری با Qwen3-VL

قابلیت دوم، ورودی تصویری است. Tinker دو مدل زبانی تصویری Qwen3-VL را ارائه میدهد که در لیست مدلهای Tinker به عنوان مدلهای Vision MoE در دسترس هستند.

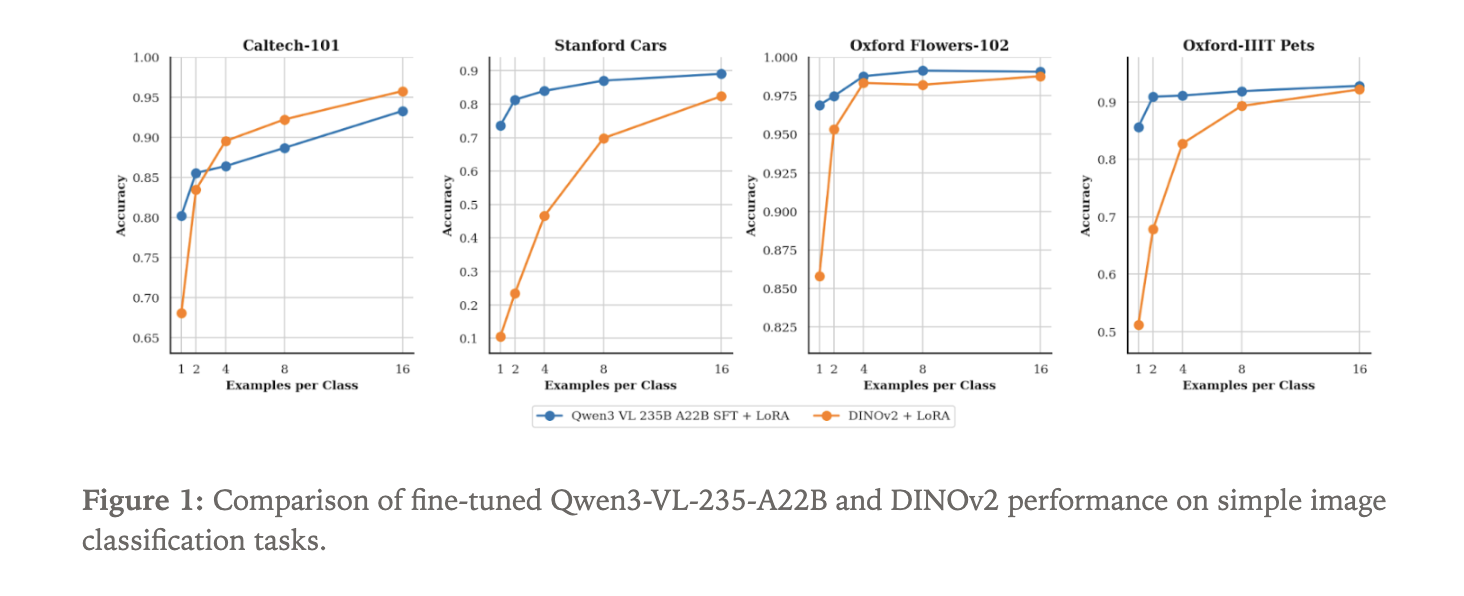

مقایسه Qwen3-VL و DINOv2 در دستهبندی تصاویر

برای نشان دادن قدرت مسیر جدید تصویری، تیم Tinker مدل Qwen3-VL-235B-A22B-Instruct را به صورت یک دستهبند تصویر تنظیم کردند. آنها از چهار مجموعه دادهی استاندارد استفاده کردند:

- Caltech 101

- Stanford Cars

- Oxford Flowers

- Oxford Pets

نکات کلیدی

- Tinker اکنون به صورت عمومی در دسترس است و ابزارهایی برای تنظیم مدلهای LLM باز فراهم میکند.

- پلتفرم از مدل Kimi K2 Thinking پشتیبانی میکند که به عنوان یک مدل استدلالی در لیست Tinker قابل تنظیم است.

- قابلیت نمونهگیری سازگار با OpenAI فراهم شده است.

- ورودی تصویری از طریق مدلهای Qwen3-VL فعال است.

- مقایسه Qwen3-VL با DINOv2 نشان داده که مدلهای زبانی تصویری از نظر کارایی داده بهتر عمل میکنند.