آزمایشگاه Thinking Machines API آموزشی Tinker را به طور عمومی عرضه کرده و سه قابلیت مهم شامل مدل استدلال Kimi K2 Thinking، نمونهبرداری سازگار با OpenAI و ورودی تصویری از طریق مدلهای زبانی دیداری Qwen3-VL اضافه کرده است. این قابلیتها برای مهندسان هوش مصنوعی امکان تنظیم مدلهای پیشرفته را بدون نیاز به زیرساختهای پراکنده فراهم میکند.

Tinker دقیقاً چه کاری انجام میدهد؟

Tinker یک API آموزشی است که بر تنظیم دقیق مدلهای زبان بزرگ تمرکز دارد و فرآیند آموزش پراکنده را ساده میسازد. شما یک حلقه پایتون ساده را روی یک ماشین تنها پردازنده اجرا میکنید، دادهها و محیط تقویتی، ضرر و منطق آموزشی را تعریف میکنید و سرویس Tinker این حلقه را روی یک دسته از GPUها اجرا میکند.

API یک مجموعه کوچک از اولویتها مانند forward_backward برای محاسبه گرادیانها و optim_step برای بهروزرسانی وزنها ارائه میدهد. این قابلیتها، منطق آموزشی را برای کسانی که میخواهند یادگیری تحت نظارت، تقویتی یا بهینهسازی ترجیحات را اجرا کنند آشکار نگه میدارد.

Availability عمومی و Kimi K2 Thinking

تغییر اصلی در بهروزرسانی دسامبر 2025 این است که Tinker دیگر نیازی به لیست انتظار ندارد و کاربران میتوانند مدلهای موجود و قیمتها را مشاهده کرده و به مثالهای آماده دسترسی پیدا کنند.

کاربران اکنون میتوانند moonshotai/Kimi-K2-Thinking را در Tinker تنظیم کنند. این مدل استدلال دارای معماری ترکیبی از متخصصان با ۱ تریلیون پارامتر است و برای زنجیرههای طولانی از تفکر و استفادهی قوی از ابزار طراحی شده است.

نمونهبرداری سازگار با OpenAI در آموزش

Tinker اکنون یک مسیر دوم برای نمونهبرداری ارائه میدهد که واسط تکمیلهای OpenAI را منعکس میکند و امکان استفاده از URI مدلها در Tinker را فراهم میکند.

ورودی تصویری با Qwen3-VL در Tinker

Tinker دو مدل زبانی دیداری Qwen3-VL را معرفی میکند که میتوانند با استفاده از API موجود برای آموزش استفاده شوند.

برای ارسال تصویر به یک مدل، شما ModelInput با ImageChunk میسازید و این قابلیتها در تنظیمات آموزشی Tinker با استفاده از LoRA آموزش داده میشوند.

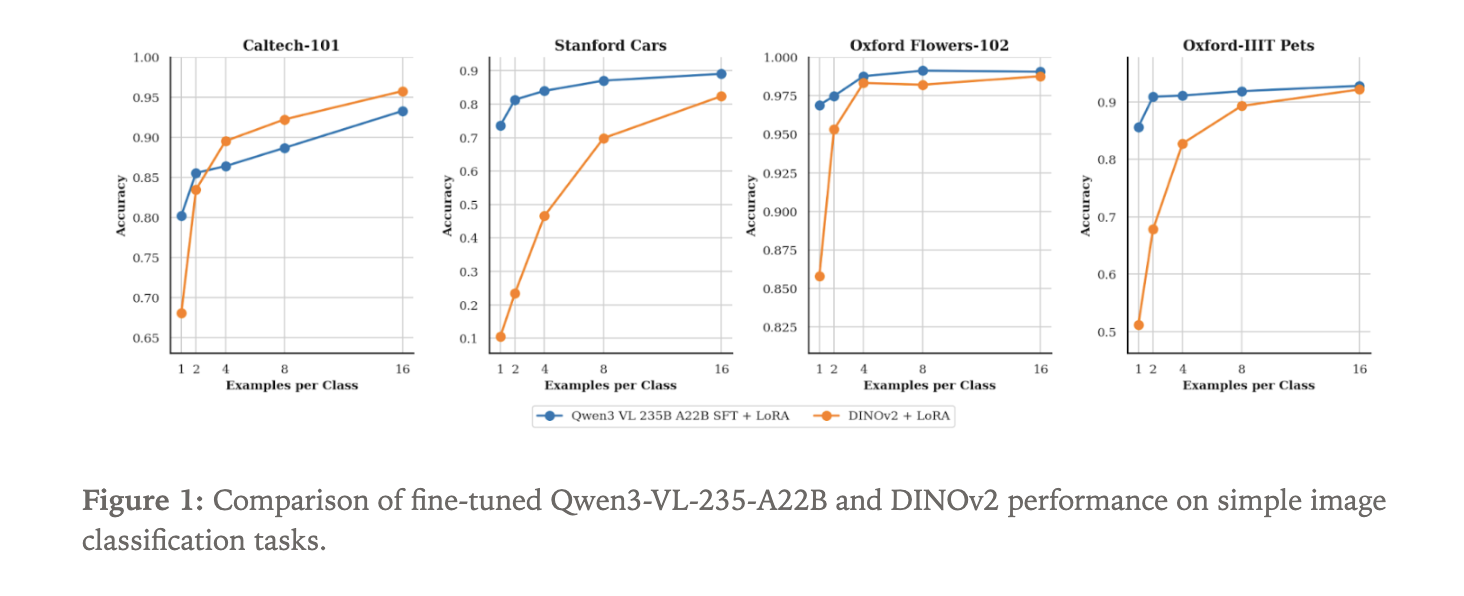

Qwen3-VL در مقابل DINOv2 در طبقهبندی تصویر

برای نشان دادن قابلیت جدید مسیر تصویری، تیم Tinker مدل Qwen3-VL-235B-A22B-Instruct را به عنوان یک طبقهبند تصویر تنظیم دقیق کردند.

- Caltech 101

- Stanford Cars

- Oxford Flowers

- Oxford Pets

هر دو مدل Qwen3-VL-235B-A22B-Instruct و DINOv2 با استفاده از آداپتورهای LoRA در Tinker آموزش دیدهاند و تمرکز بر کارآیی داده است.

نکات کلیدی

- Tinker اکنون به صورت عمومی در دسترس است و امکان تنظیم دقیق LLM ها را با یک حلقه آموزشی پایتون فراهم میکند.

- این پلتفرم مدل استدلال Kimi K2 Thinking را که یک مدل ترکیبی از متخصصان با ۱ تریلیون پارامتر است، پشتیبانی میکند.

- Tinker واسط پیشبینی سازگار با OpenAI را در اختیار کاربران قرار میدهد که به کمک آن میتوانید از نقاط بازرسی مدل استفاده کنید.

- ورودی تصویری از طریق مدلهای Qwen3-VL پشتیبانی میشود و امکان ساخت خطوط لوله آموزشی چندوجهی را فراهم میکند.

- آزمایشها نشان میدهد که Qwen3-VL 235B عملکرد قویتری در طبقهبندی تصویر نسبت به مدل پایه DINOv2 دارد.